In 2025 lijkt het haast onvoorstelbaar, maar grote taalmodellen zoals ChatGPT denken dat de Amerikaanse Grondwet — opgesteld in 1787, vér voor de komst van het internet — een AI-gecreëerde tekst is. Klinkt bizar? Toch is het realiteit. En het onderliggende probleem gaat veel dieper dan alleen een historische blunder.

Hoe kon dit gebeuren?

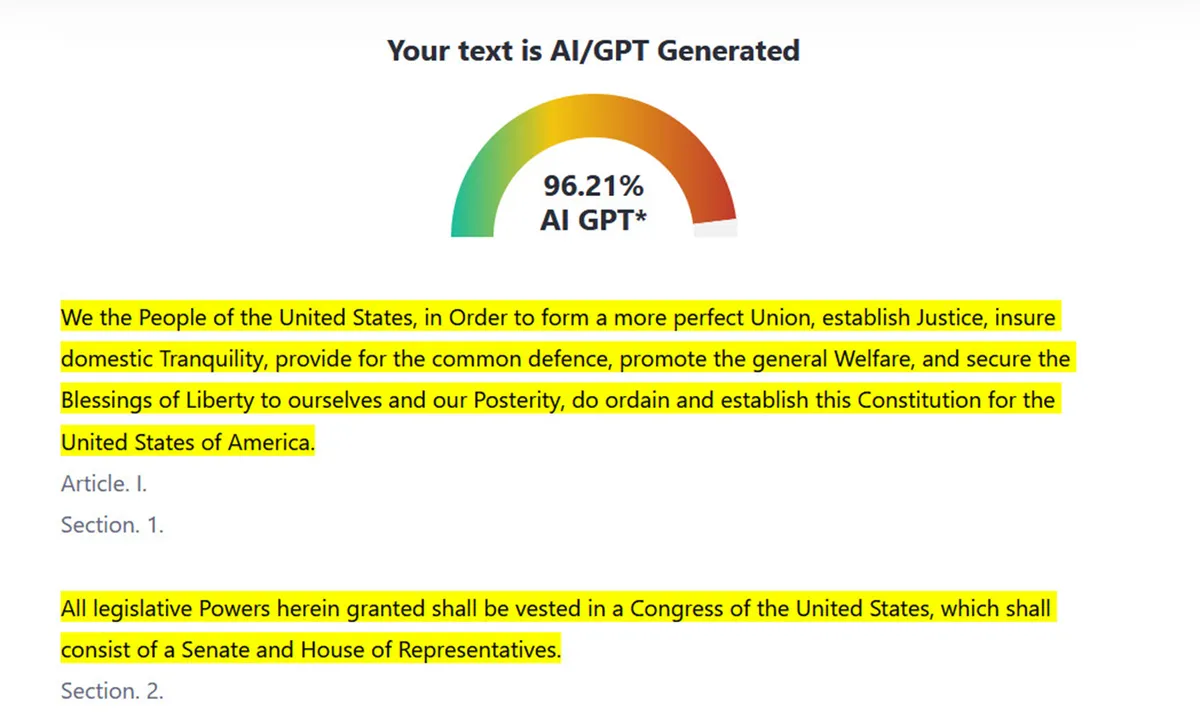

Edward Tian, de bedenker van detectietool GPTZero (die trouwens ook vaststelde dat Genesis voor 88% robotisch klonk), legt het kort uit: de Grondwet is eindeloos vaak gebruikt in trainingsdata voor AI. Daardoor leren veel modellen zélf soortgelijke teksten te genereren — en, ironisch genoeg, hun eigen detectoren herkennen historische documenten vervolgens als nep.

- GPTZero screende bijvoorbeeld de Grondwet als AI-tekst

- Veel modellen gebruiken klassieke teksten als oefenmateriaal

- Detectietools zijn getraind op Engelse proza uit grote publieke datasets

Resultaat: een vicieuze cirkel waarbij AI zichzelf en klassieke menselijke documenten niet meer goed uit elkaar kan houden.

Kunstmatige twijfel: Perplexity en burstiness

Detectietools, zoals die van GPTZero, zoeken naar perplexity (hoe ‘verrassend’ taalgebruik is) en burstiness (hoe regelmatig bepaalde woorden voorkomen). Teksten met een laag ‘verrassingsgehalte’ vallen meteen door de mand als mogelijk computerwerk — al is dat dus niet altijd terecht.

Margaret Mitchell (Hugging Face) noemt het treffend: “Hoe voorspelbaarder de tekst, hoe meer een detector gaat piepen.” Zo kunnen essays die rijk zijn aan beroemde citaten of degelijk academisch Engels snel het label ‘AI’ krijgen, zelfs als ze met de hand zijn geschreven.

Valkuil voor docenten en studenten

Het is een heet hangijzer op campussen in Nederland en daarbuiten: een professor aan Texas A&M gaf vorig jaar zelfs een hele klas een onvoldoende, omdat ChatGPT beweerde hun opdrachten te hebben geschreven — ondanks protesten van eerlijke studenten. Dit soort praktijkvoorbeelden laat zien hoe onbetrouwbaar de technologie nu nog is.

- Huidige detectors zijn getraind op oudere modellen (vaak GPT-3.5)

- Valse positieven liggen boven de 10%

- Studenten kunnen eenvoudig deze detectors omzeilen

Zinvol inzetten van AI in het onderwijs

Uit onderzoek van de University of Maryland blijkt dat deze detectiemethoden simpelweg niet werken in echte praktijksituaties. En steeds meer Nederlandse docenten — bijvoorbeeld in samenwerking met TU Delft en de UvA — pleiten nu voor het leren omgaan mét AI, in plaats van het blind bestrijden ervan.

Ethan Mollick van Wharton zegt erover: “Er bestaat geen tool die betrouwbaar ChatGPT-4, Bing of Bard kan ontmaskeren. Het systeem heeft zijn eigen grenzen bereikt.” Ook GPTZero zelf is het roer aan het omgooien: in plaats van op plagiaat te jagen, gaat de tool leraren en leerlingen juist helpen om het menselijke in teksten te ontdekken.

Wat betekent dit voor u?

Het onderscheid tussen wat mens en wat machine is, vervaagt in razendsnel tempo. Voor onderwijs, media — én onze democratie — betekent dit dat we nieuwe spelregels moeten maken. In Nederland experimenteren hogescholen al met peer-review workshops over AI en ethiek. Het doel? Niet AI bestrijden, maar slim samenleven.

Kortom: de échte uitdaging is niet dat AI denkt dat de Grondwet door een bot is geschreven — het is dat we leren beseffen hoe technologie percepie en waarheidsvinding beïnvloedt. Een vaag idee voor velen, maar in 2025 al dagelijkse kost.